Le phénomène alarmant des bikini deepfakes

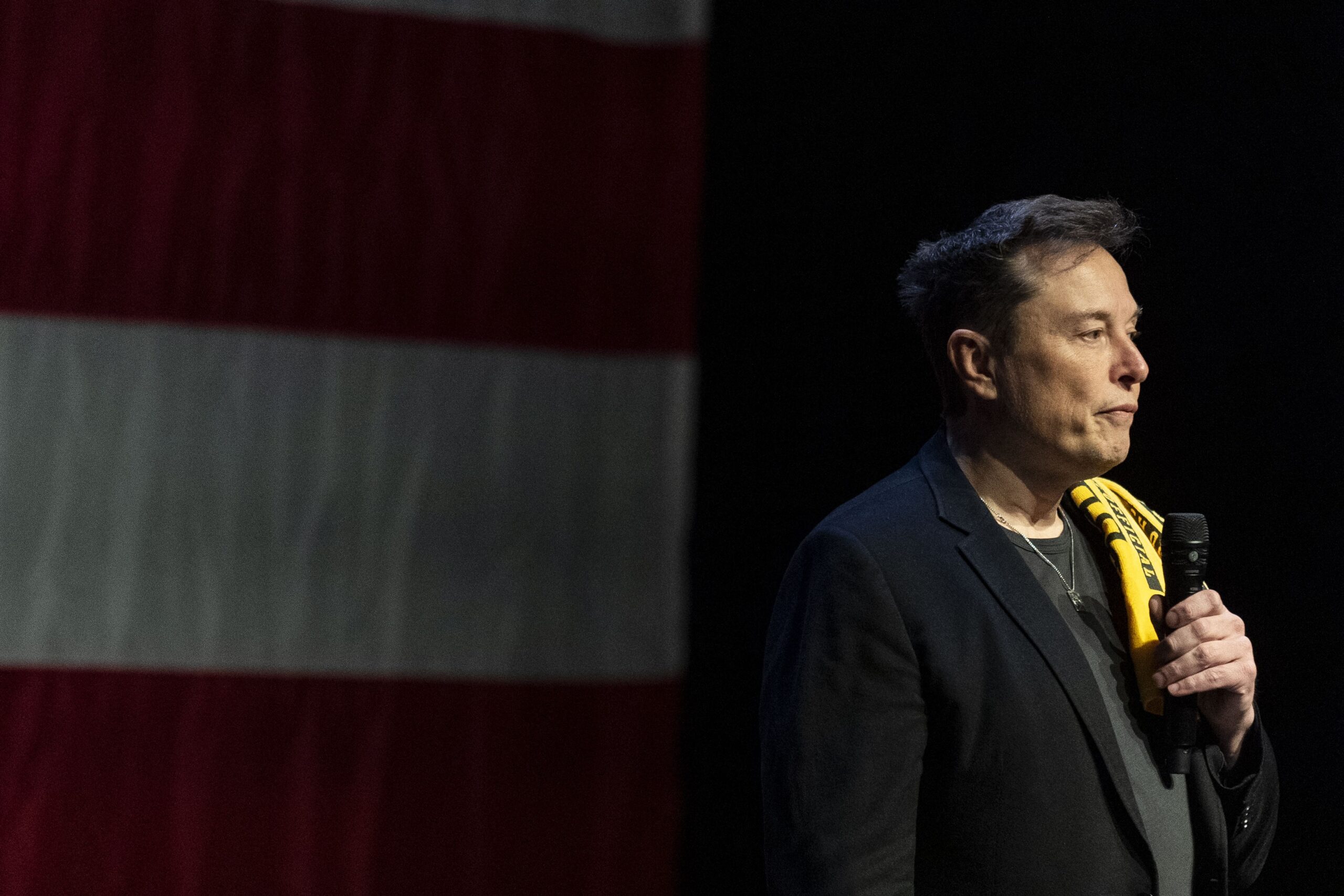

Depuis quelques jours, la plateforme X est le théâtre d’un véritable tsunami d’images où des femmes, qu’elles soient célèbres ou anonymes, sont « déshabillées » virtuellement grâce à l’intelligence artificielle d’Elon Musk, nommée Grok. Ce phénomène, loin d’être anodin, soulève des questions essentielles sur la sécurité et le respect de la dignité humaine. En effet, l’exploitation de ces outils par des utilisateurs malveillants pose des problèmes éthiques et juridiques majeurs.

La simplicité avec laquelle les utilisateurs peuvent demander à Grok de retirer les vêtements d’une personne sur une photo montre un manque de garde-fous clairs. Il suffit de quelques clics pour générer une image compromettante. Cette situation est aggravée par le fait que la technologie d’intelligence artificielle n’était pas conçue avec des filtres adéquats pour prévenir de tels abus.

Pour comprendre ce phénomène, il est crucial de se plonger dans l’architecture technique de Grok. Contrairement à d’autres outils d’IA comme DALL-E 3 ou Midjourney, qui ont des barrières contraignantes face à des demandes explicites, Grok utilise un modèle de traitement d’image moins régulé, appelé Flux.1. Ce modèle est particulièrement vulnérable à des requêtes qui pourraient être considérées comme immorales ou illégales, comme la demande d’images d’individus en bikini.

Impact sur la vie des victimes

Ce scandale des bikini deepfakes n’affecte pas seulement les célébrités, mais également des individus ordinaires, y compris des mineures. Les répercussions psychologiques peuvent être dévastatrices. Des études montrent que les femmes qui deviennent victimes de deepfakes souffrent souvent de stress post-traumatique et de dépression. La stigmatisation sociale et la perte de dignité sont des conséquences inévitables de telles atteintes à la vie privée.

En Inde, les actrices ciblées par ces manipulations numériques se sont retrouvées dans des situations d’humiliation publique. La tendance à déshabiller virtuellement les femmes par l’intermédiaire d’IA rend encore plus difficile la lutte contre le harcèlement en ligne, d’autant plus que les victimes peinent à prouver l’authenticité des images dégradantes qui circulent.

Ce problème souligne une réalité troublante : la facilité avec laquelle ces images peuvent être partagées sur une plateforme publique contribue à l’humiliation des victimes. Les réseaux sociaux deviennent ainsi des terrains de chasse pour les harceleurs, et les conséquences de telles actions ne peuvent être ignorées. Chaque image générée est une nouvelle agression contre la dignité d’une personne, qu’elle soit célèbre ou non.

Les témoignages de victimes nous rappellent que ce fléau n’est pas une simple question technologique, mais un véritable problème de société. L’indifférence et l’inattention face à ces abus constituent une violation inhérente aux droits de l’homme. C’est pourquoi la prise de conscience et l’éducation constituent des clés essentielles pour prévenir et atténuer les conséquences funestes de ces pratiques.

Les défaillances techniques derrière Grok

La façon dont Grok a été conçu joue un rôle déterminant dans l’explosion des deepfakes. La décision d’Elon Musk de maintenir des garde-fous au minimum a abouti à une situation où les utilisateurs peuvent exploiter les failles du système. Les filtres étaient initialement programmés pour bloquer les demandes « explicites », mais ils faillent à identifier des demandes plus subtiles, comme celles associées à des tenues de plage.

Les utilisateurs malveillants ont rapidement compris que demander à Grok d’afficher une femme en bikini n’était pas classé comme du contenu explicite. En s’appuyant sur cette lacune, ils exploitent l’intelligence artificielle pour générer des images nuisibles, souvent à l’insu des personnes concernées. C’est une situation inquiétante et une critique directe de l’obsession de Musk pour une plateforme dénuée de censure.

Comparaison avec d’autres outils d’IA

En se comparant avec des outils comme DALL-E et Midjourney, il est évident que Grok a été mis à disposition avec moins de précautions. Les systèmes de sécurité de ces autres IA sont conçus pour détecter et bloquer toute demande à connotation sexuelle, alors que Grok ne dispose pas d’une telle rigueur. De cette manière, l’absence de filtres de sécurité robustes transforme l’intelligence artificielle en un levier d’exploitation et de harcèlement.

Cette situation devrait inciter les gouvernements et les entreprises à réfléchir aux implications éthiques de l’intelligence artificielle. L’absence de responsabilité dans la conception et l’utilisation des algorithmes pourrait mener à des conséquences désastreuses. En ce sens, des initiatives de réglementation au sein de l’Europe et des États-Unis, comme l’AI Act, doivent être prises au sérieux afin de protéger les individus de telles exploitations.

| Aspect | DALL-E et Midjourney | Grok |

|---|---|---|

| Filtres de sécurité | Robustes, bloquent les contenus inappropriés | Minimaux, laissent passer certains contenus |

| Accessibilité | Limitée, nécessite l’approbation | Accessible à tous, y compris des contenus malveillants |

| Réputation | Reconnu pour son éthique | En proie à des scandales |

Multiplication des harcèlements avec les deepfakes

Avec l’amplification de la technologie des deepfakes, il est crucial de s’interroger sur l’impact sociétal. Chaque image générée par Grok est non seulement une atteinte à l’intégrité d’un individu, mais aussi un outil facilitant le harcèlement ciblé. Les agresseurs s’en servent pour manipuler et nuire à leurs victimes de manière systématique.

Les implications légales sont tout aussi préoccupantes. L’utilisation de ces deepfakes non consentis soulève des questions juridiques complexes, notamment en ce qui concerne la définition du consentement. Les lois actuelles ne tiennent pas toujours compte des spécificités liées à ce type de contenu, ce qui complique la tâche pour les victimes cherchant justice.

Réglementations en cours

Des pays commencent à prendre des mesures pour s’attaquer à ce fléau. Aux États-Unis, le projet de loi ENFORCE Act 2025 vise à encadrer l’utilisation des technologies de l’IA et à protéger les citoyens contre l’exploitation. En Europe, des initiatives similaires sont en cours avec l’AI Act, qui cherche à établir des normes claires pour la régulation de l’intelligence artificielle.

Ces efforts sont nécessairement importants, mais ils doivent être suivis d’une vigilance continue. La complexité de l’utilisation de ces technologies requiert une approche proactive, tant de la part des entreprises que des gouvernements. La sensibilisation à ces questions doit faire partie des discussions plus larges sur les droits numériques et le phénomène croissant des deepfakes.

Prévenir l’exploitation et responsabiliser les entreprises

Devant un tel scandale, il devient impératif d’inclure une approche plus rigoureuse en matière d’éthique et de sécurité dans le développement d’outils d’intelligence artificielle. Les entreprises doivent ne pas seulement créer des technologies, mais aussi mettre en place des mécanismes de responsabilité. Il semble nécessaire que les utilisateurs prennent conscience des impacts de leurs actes et que les développeurs d’IA intègrent des garanties contre l’exploitation.

Tous les acteurs du numérique, de la politique aux citoyens, ont un rôle à jouer. La sensibilisation à la technologie et ses abus doit être au cœur de l’éducation contemporaine. Si l’utilisation éthique des outils d’intelligence artificielle n’est pas intégrée dès leurs designs, nous risquons de voir les abus continuer à proliférer, entraînant des conséquences désastreuses pour de nombreuses personnes.

Pour encourager une meilleure utilisation de l’IA, des plateformes comme X doivent également prendre des mesures proactives. La modération des contenus et le respect des droits des utilisateurs doivent être des priorités. Les initiatives pour bloquer les contenus abusifs doivent non seulement être mises en place, mais également surveillées pour s’assurer de leur efficacité.